Thermodynamics imposes the biophysical boundaries to human civilisation

The entropy law and the economic process

Termodinámica del proceso económico

Termodinámica

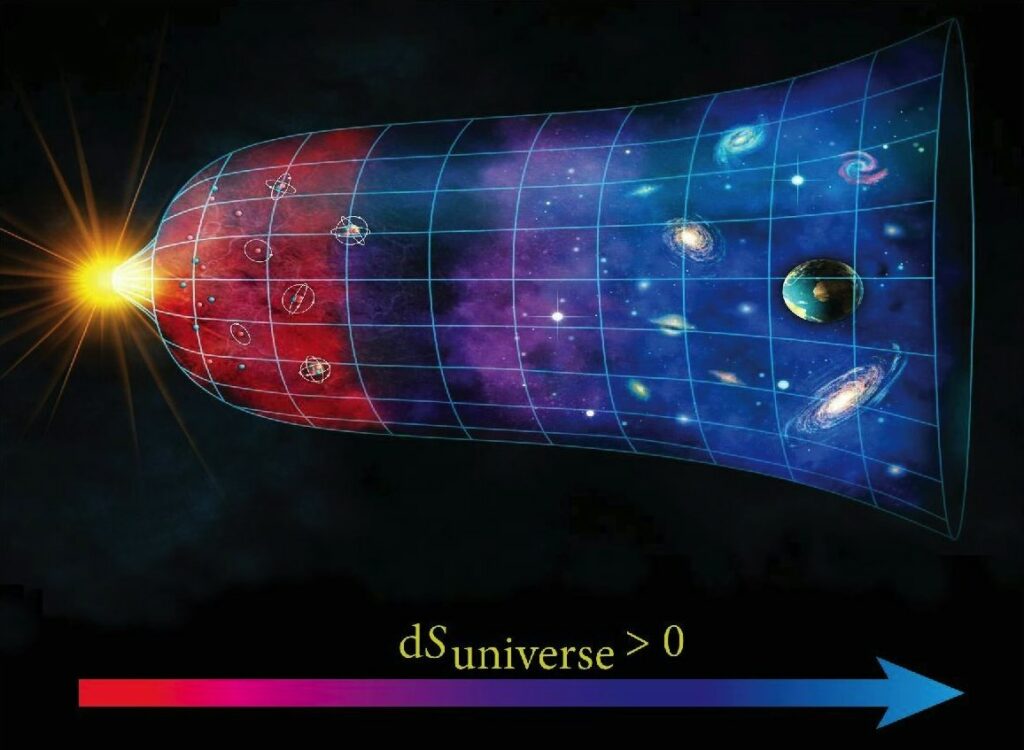

La termodinámica es la rama de la física que estudia las relaciones entre el calor, el trabajo, la temperatura y la energía. Estudia cómo la energía se transforma y cómo rige los procesos naturales y las actividades humanas, la tecnología, el comportamiento de las estrellas o de los motores y de las reacciones químicas. La ley de conservación de la energía y de la materia y la ley de la entropía rigen el comportamiento del universo. Leyes físicas que establecen que la energía total y la materia total del universo se mantienen constantes, pero que la entropía —el desorden, o disipación de la energía y de la materia— se incrementa indefinidamente, porque los procesos de transformación de energía o materia son irreversibles. Conclusión: el universo se dirige hacia el desorden, al caos y, finalmente —en un tan distante futuro que nunca veremos— a la muerte térmica[1].

Las leyes de la termodinámica son clave para la ecología en la comprensión de flujos de energía y materiales a través de las redes tróficas entre los seres vivos, entre los sistemas ecológicos y de la biosfera en su conjunto (Figuras 1 y 2). Asimismo, la termodinámica es fundamental para las ingenierías en el aprovechamiento de fuentes de energía y su transformación en formas utilizables para la producción de bienes y servicios.

En particular, la termodinámica permite comprender la diferencia entre procesos reversibles e irreversibles (la flecha del tiempo); de lo cual la teoría económica no parece haberse dado por enterada.

Trabajo y energía

Como decía Marx (1979)[2], la fuente de toda riqueza no es solamente el trabajo, sino también los recursos que la naturaleza ofrece al ser humano[3]. De hecho el trabajo es, en sí mismo, una fuerza de la naturaleza, la fuerza humana de trabajo.

El trabajo es esencial de la naturaleza humana, porque produce los bienes para la supervivencia, la reproducción y el bienestar. Para realizarlo es indispensable tener energía. ¿De dónde proviene esta energía? De la alimentación, la cual a su vez proviene —directa (plantas) o indirectamente (animales)— de la fotosíntesis. Ejemplo clásico para explicar cómo se transforma la energía, a partir de una fuente —el sol—, en otra fuente de energía —biomasa alimentaria— que, por digestión y metabolismo, se transforma en energía química corporal que nos mantiene vivos y activos para poder generar un producto: un producto del trabajo.

¿Qué es, entonces, la energía? En términos generales la energía es la capacidad de producir movimiento, un cambio; en general: la capacidad de un sistema de realizar un trabajo[4]; por ejemplo, levantar un objeto o transmitir calor. Se trata de una de las nociones más elementales de la física. Es un concepto abstracto, porque la energía no se ve, sólo sus efectos pueden observarse: movimiento, calor, luz. Desde el punto de vista de la física, la energía se manifiesta de diversas formas:[5]

- energía cinética (del movimiento)

- mecánica, la de objetos en movimiento (automóviles, viento, ríos, mareas);

- térmica, calorífica (grado de agitación de átomos o moléculas de una sustancia, mayor a mayor temperatura);

- radiante, transportada por ondas electromagnéticas (luz solar, rayos X, ondas de radio);

- eléctrica, cuando los electrones fluyen a través de conductores (corriente eléctrica, medida en Amperes, una vez prendido un interruptor).

- energía potencial (la almacenada)

- gravitatoria, debido a la posición de un objeto (aguas retenidas en una presa);

- química, almacenada en los enlaces moleculares de las sustancias (que se libera en reacciones químicas como la combustión, la digestión de alimentos, o el uso de una batería eléctrica);

- nuclear, la almacenada en el núcleo de los átomos (fuente de la energía de las estrellas, o de las centrales nucleares);

- eléctrica, cuando almacenada en una batería, o en tensión (medida en Volts, antes de prender un interruptor).

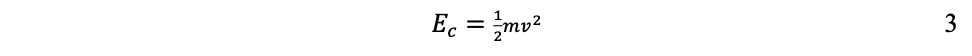

Por ejemplo, entre más rápidamente se desplace un objeto y/o entre más pesado sea, mayor será su energía cinética. En física clásica, la energía cinética (Ec) es una función de la masa (m) y de la velocidad (v):

Como se observa en la ecuación 3, en la energía cinética la velocidad influye más que la masa. Por eso un choque entre automóviles es mucho más fuerte a mayor velocidad que a mayor peso de ellos.

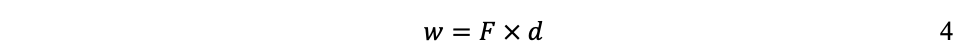

Recordando que en física clásica: la velocidad (v) se mide como distancia (d) entre tiempo (t); la aceleración (a) se mide como velocidad entre tiempo (v/t); y la fuerza (F) como masa veces aceleración (m ´ a); la manera de medir el trabajo (w) es:

Donde d se mide en metros (m); t en segundos (s); F en Newtons (N); w se mide en Joules (J); y m en kilogramos (kg).[6]

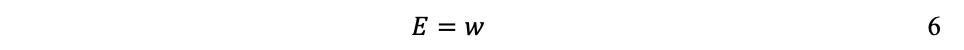

Si la energía (E) es la capacidad de realizar un trabajo (w), éste es la capacidad de realizar una transferencia de energía. La energía es una atribución del estado de un sistema, en tanto que el trabajo es una atribución del proceso de transferencia de energía que realiza un sistema. Tanto el trabajo como la energía se miden en Joules.

Tipos de sistemas

Un sistema es una porción del universo que interesa distinguir o estudiar. Los sistemas termodinámicos pueden ser abiertos, cerrados o aislados[7]. Un sistema abierto es aquel que intercambia masa y energía (generalmente en forma de calor) con sus alrededores; un sistema cerrado solamente intercambia energía, pero no masa; y un sistema aislado no intercambia ni masa ni energía.

Por eso, desde el punto de vista termodinámico, los ecosistemas y los seres vivos somos sistemas abiertos, porque continuamente intercambiamos masa y energía con nuestro entorno (respirar, beber, comer, transpirar, evacuar). Tanto como el sistema económico (flujo de materiales y energía) —aunque los economistas lo traten como si fuera un sistema aislado. El Sistema Tierra puede ser considerado un sistema cerrado, pues recibe enormes cantidades de energía solar e irradia calor hacia el espacio, pero prácticamente no intercambia materia (meteoritos de masa insignificante para la masa de la Tierra y pérdida a cuentagotas de hidrógeno que escapa de las más altas capas de la atmósfera). Estrictamente, sólo el universo es un sistema aislado porque, al carecer de entorno, no intercambia ni materia ni energía.

Energía interna y energía térmica

La energía interna U de un sistema corresponde a la energía cinética y la energía potencial acumulada de todos los átomos o moléculas que lo constituyen; lo cual depende de la naturaleza química y física de sus átomos y moléculas, de su temperatura y, bajo ciertas condiciones, de la presión y el volumen. No es posible cuantificar el valor absoluto de U, pero lo que interesa en termodinámica es el cambio de energía interna Uf – Ui entre la energía inicial Ui y la energía final Uf. En particular, la termodinámica se interesa en la energía térmica E y cuando se produce un calentamiento o un enfriamiento del sistema. Es decir, un cambio de energía térmica ∂E = Ef – Ei, que se mide por el cambio de temperatura y que corresponde —a diferencia de U— solamente a la energía cinética acumulada del movimiento de todos sus átomos o moléculas (Crockford H.D. & Knight S.B. 1968). Por ejemplo, a igual temperatura el océano contiene mucho más energía térmica que un vaso de té, porque contiene muchas más moléculas. Así, la energía térmica E se genera cuando se incrementa la energía cinética interna de un sistema, como es el caso de la energía solar al impactar la superficie terrestre; o por fricción, por fisión nuclear, o por combustión.

A partir de la domesticación del fuego, manipulamos la energía térmica exosomática[8] desde hace cientos de miles años. Y actualmente la utilizamos en muchísimas actividades productivas para: generar electricidad, muy diversos procesos industriales, motores de combustión interna, altos hornos, calefacción y refrigeración, cocinar.

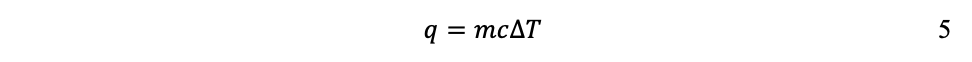

La transferencia de energía térmica, de un sistema a otro, se denomina calor y se cuantifica midiendo las temperaturas de ambos sistemas. Transferencia que sucede en un solo sentido: del sistema más caliente hacia el más frío, del de mayor temperatura hacia el de menor temperatura, independientemente de su tamaño. Para medir la transferencia de calor se utiliza el calor específico (c), que indica la energía térmica necesaria para elevar 1ºC la temperatura de 1g de una sustancia dada. De tal modo que, en general, la cantidad de energía térmica q requerida para elevar la temperatura de un sistema dependerá de la diferencia de temperaturas inicial y final:

y de su masa m:

Donde q se mide en Joules (J) o en calorías (cal[9]), m en kg y T en Centígrados o grados Kelvin.

Fuentes de energía

Existen dos tipos de fuentes de energía:

- de flujo —renovables: el sol, el viento, hidráulica, geotérmica (a escala humana) y biomasa.

- de stock —no renovables: combustibles fósiles, geotérmica (a escala geológica) y nuclear.

También se distinguen según su disponibilidad directa o indirecta. Las fuentes primarias de energía se encuentran en estado natural: solar, eólica, geotérmica, petróleo crudo o minerales de uranio. Las fuentes secundarias de energía han sido convertidas a partir de las primarias: electricidad, gasolinas, o hidrógeno.

Y en términos biológicos puede distinguirse entre energía endosomática —la energía química corporal que utilizamos por sobrevivir y trabajar— y energía exosomática —la que nos ofrecen los recursos naturales (biomasa alimentaria, biomasa combustible, combustibles fósiles, hidráulica, geotérmica, nuclear).

Combustibles fósiles: un subsidio ecológico

Es muy importante comprender que, desde el punto de vista de la teoría ecológica, los combustibles fósiles constituyen un subsidio ecológico que ha hecho posible la Gran Aceleración (Figura 10); el crecimiento exponencial de la industrialización (evolución humana exosomática) y de la población (biomasa humana, Figura 5; número de individuos, Figuras 6 y 7). Fósiles porque provienen de biomasa de hace millones de años. El carbón fósil se formó durante el periodo Carbonífero, hace 360 a 300 millones de años, cuando la Tierra estaba cubierta de vastos bosques pantanosos llenos de helechos gigantes y musgos, de los cuales proviene el carbón. El petróleo y el gas se formaron durante la Era Mesozoica, hace 252 a 66 millones de años y provienen fundamentalmente del plancton de entonces.

Por eso los combustibles fósiles constituyen un subsidio ecológico (Odum, H.T. 1971), porque son biomasa —fosilizada— proveniente de fotosíntesis del pasado remoto. Dicho de otro modo, energía de flujo (solar) del pasado que, por procesos geológicos, quedó almacenada como energía de stock (química), que utilizamos como fuente de energía primaria adicional a la solar, con base en la cual ha sido posible una civilización industrial de crecimiento exponencial y que la población global de Homo sapiens creciera mucho más de lo que permite la capacidad de carga de la biosfera (Figura 5).

La cuestión estratégica de largo plazo es cómo sustituir las colosales cantidades de energía primaria disponible de los combustibles fósiles que requiere nuestra civilización industrial, con fuentes alternativas de energía. Nada indica que esto sea posible (Smil, V., 2022).

Leyes de la termodinámica

La termodinámica tiene cuatro leyes (Crockford H.D. & Knight S.B. 1968). No todas establecidas de una sola vez, ni en el orden que hoy las conocemos, pues son el resultado de un proceso de varias décadas, involucrando a numerosos investigadores que buscaban comprender la naturaleza del calor y de la eficiencia de las máquinas de vapor. Por lo que, en general, la termodinámica estudia sistemas cerrados —que intercambian solamente energía con su entorno, pero no materia. Típicamente estudia sistemas de un cilindro que contienen un gas, con un pistón que permite incrementar o reducir la presión (P), el volumen (V) o la temperatura (T) del gas, de tal manera que si la energía interna (E) se mantienen constante, la energía recibida o transferida hacia el exterior es equivalente al trabajo (w) realizado por, o sobre, el sistema:

Antes de que la termodinámica definiera el calor como el movimiento de los átomos (teoría cinética), los científicos intentaban averiguar por qué el calor se desplazaba de los cuerpos calientes a los fríos. Durante el siglo XVIII Antoine Lavoisier[10] —reconocido como padre de la química moderna que estableció la ley de la conservación de la masa—, desarrolló una teoría para explicarlo; errónea en su consideración de que el calor era una sustancia, un fluido, pero que sentó las bases matemáticas que más tarde utilizaría Sadi Carnot (ver más abajo), para postular la segunda ley de la termodinámica.

La primera ley de la termodinámica se estableció durante las décadas de 1840 y 1850, con las contribuciones de Julius Robert von Mayer, James Prescott Joule y Hermann von Helmholtz, entre otros, quienes cuestionaban la idea dominante de la época y demostraron que el calor no era una sustancia, sino una forma de energía. El experimento más conocido para demostrarlo es el de Joule, al hacer caer un peso para hacer girar una paleta en el agua, demostrando que el trabajo mecánico elevaba la temperatura del agua; con lo cual estableció el equivalente mecánico del calor, es decir, que cierta cantidad de trabajo puede producir una cierta cantidad de calor.

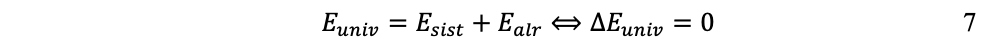

Así, la ley de la conservación de la energía establece que la energía no se crea ni se destruye, sólo se transforma. Por consiguiente, la energía total de un sistema aislado, el universo, es constante. Para efectos teóricos y experimentales, la energía se distingue entre la del sistema y la de sus alrededores:

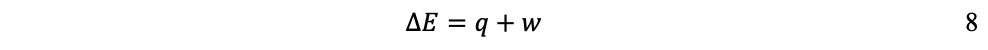

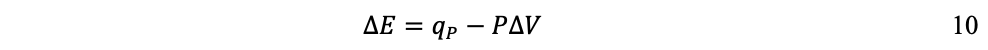

En síntesis, el primer principio reconoce la conservación de la energía, que no se crea, ni se pierde, sólo se transforma, de una a otra forma de energía. De tal modo, la primera ley explica que el cambio de energía interna ∂E de un sistema puede expresarse como la suma de la cantidad de calor (q) transferido más el trabajo (w) realizado:

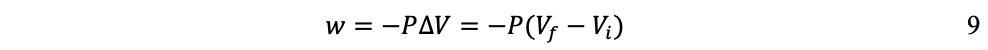

Este cambio de energía interna puede realizarse a temperatura (T), o volumen (V), o presión (P) constantes, dependiendo del sistema[11]. En termodinámica, el tipo de trabajo más común es a presión constante y volumen variable, que sucede cuando un sistema (un gas) se expande o se comprime. Trabajo (w) que se expresa como:

Así, si el sistema se expande (∂V es positivo), se realiza trabajo hacia el entorno y w es negativo, pues el sistema pierde energía; en cambio, si el sistema se comprime (∂V es negativo), se realiza trabajo hacia el sistema y w es positivo, pues el sistema gana energía. Por ejemplo, en el caso de un sistema en el que el gas se expande a presión constante —como una máquina de vapor—, la ecuación 8 se expresa:

Donde qp es la cantidad de calor transferido a presión constante y el trabajo es la expansión del gas:

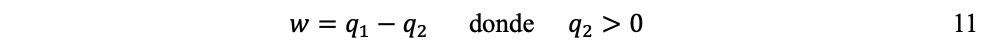

La segunda ley la esbozó Sadi Carnot en 1824. Carnot se interesaba en la eficiencia de las máquinas de vapor y quería saber cuál era el rendimiento teórico máximo de un motor. Su obra Réflexions sur la puissance motrice du feu[12]permitió comprender: (1) que para que un motor produzca trabajo se requiere un flujo de calor a partir de una fuente caliente (q1, la caldera), hacia un fuente fría (q2, el condensador); y (2) que es imposible convertir todo el calor en trabajo, pues una fracción se pierde inevitablemente hacia la fuente fría y el entorno:

Es decir, mientras que el proceso mecánico del sistema es reversible: el pistón que se levanta, al caer restablece el estado inicial del sistema; el proceso termodinámico es irreversible: porque q2 > 0 y el pistón solamente puede elevarse nuevamente si se suministra energía desde el exterior.

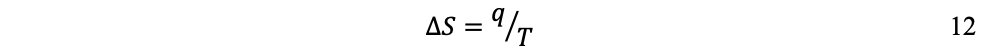

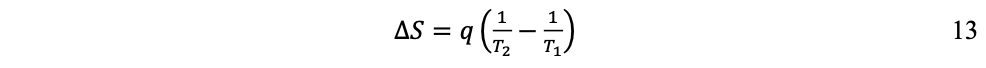

Esta idea fue formalizada a mediados del siglo XIX por Rudolf Clausius y Lord Kelvin con la noción de entropía, para describir la irreversibilidad del proceso de conversión de calor en trabajo; conversión en la cual la transferencia de energía térmica siempre va desde lo caliente hacia lo frío e imposible en sentido contrario. Según la definición de Clausius, si una cantidad de calor q fluye hacia un gran depósito de calor a una temperatura T, entonces el aumento de entropía S es:

Para demostrar el principio de irreversibilidad se consideran dos depósitos de calor R1 y R2 a temperaturas T1 y T2 (por ejemplo, una plancha y un bloque de hielo). Si una cantidad de calor q fluye de R1, la plancha, hacia R2, el bloque de hielo, el cambio neto de entropía para los dos depósitos es:

Cambio positivo porque T1 > T2. Es decir, el hecho que el calor nunca fluya espontáneamente de frío a caliente es equivalente a requerir que el cambio neto de entropía sea positivo para un flujo de calor. Cuando T1 = T2 los depósitos alcanzan equilibrio térmico, no existe más flujo de calor y ΔS = 0.

En general, la irreversibilidad es el sentido único de las transformaciones espontáneas, siempre desde estados menos desordenados (baja entropía) hacia estados más desordenados (alta entropía), imposible en sentido contrario. Por ello, lasegunda ley de la termodinámica, la entropía, es una medida del grado de desorden, aleatoriedad o incertidumbre de un sistema: cuanto más desordenado está un sistema, mayor es su entropía. Y la entropía de un sistema aislado (el universo) se incrementa a través del tiempo, nunca se reduce.

El establecimiento de la entropía y la segunda ley de la termodinámica constituye un evento decisivo de la aventura humana. El mismo Albert Einstein se refirió a ellas como las únicas ideas sobre el funcionamiento del universo que nunca serían refutadas. [13]

La tercera ley fue establecida por Walther Nernst, en 1906, quien, al estudiar algunas reacciones químicas a muy bajas temperaturas observó que la entropía de los sistemas tendía hacia un valor mínimo, constante, conforme se aproximaba al cero absoluto (–273.15ºC). Esto condujo al postulado teórico de que la entropía de un cristal perfecto es cero, es decir, que en tal estado un sistema —por extrapolación— se encuentra en un orden perfecto (aunque en la práctica sea imposible alcanzar el cero absoluto).

Y la cuarta ley, o principio cero, fue la última en formalizarse, en 1931, por Ralph H. Fowler: si un cuerpo A está en equilibrio térmico con un cuerpo C y si otro cuerpo B está en equilibrio térmico con el mismo cuerpo C, entonces A y B también se encuentran en equilibrio térmico entre sí. Parece trivial, pero este principio fundamenta el uso de los termómetros, al reconocer que la temperatura es medible y transmisible. Fue el último principio en establecerse, pero se le denominó principio cero por considerarlo más fundamental que los otros.

Finalmente, un concepto fundamental es el de equilibrio termodinámico, estado de reposo completo de un sistema cuando no hay más flujos de energía o materia al interior del sistema o con sus alrededores. Deben cumplirse, simultáneamente, tres condiciones: equilibrio térmico (temperatura uniforme, no hay transferencia de calor de una parte a otra del sistema); equilibrio mecánico (presión uniforme, fuerzas mecánicas en equilibrio); y, equilibrio fisicoquímico (la composición material del sistema es estable, no hay reacciones químicas netas, no hay difusión de materia). Como corolario, para un sistema aislado el equilibrio termodinámico corresponde al estado de máxima entropía.

…

El proceso económico

Administrar la escasez

Abordando en el presente ensayo las apremiantes cuestiones que derivan de los límites planetarios para el crecimiento resulta irónico que la teoría económica se base sobre la escasez como concepto central. Que parta del reconocimiento de que mientras nuestras necesidades y deseos son ilimitados, los recursos para satisfacerlos son limitados.

Así, el objeto de estudio de la economía es cómo los individuos, las empresas y los gobiernos toman decisiones para asignar estos recursos escasos con el fin de satisfacer mejor sus necesidades. Y como no es posible tener todo lo que se desea, cada elección implica un sacrificio (adquirir el producto x, en lugar del y). De donde proviene el concepto de costo de oportunidad: el valor de la mejor alternativa a la que se renuncia cuando se hace una elección.

Teorías económicas

Antes de exponer cómo la dimensión termodinámica rige el proceso económico (siguiente sección), hay que señalar que esta crítica ha sido dirigida fundamentalmente a la corriente dominante en teoría económica, la neoclásica, que asume como perfectos la racionalidad del Homo economicus, el equilibrio de mercados y la información. Otras teorías económicas[14] han desarrollado críticas, desde diversos enfoques, a la teoría neoclásica, buscando describir de manera alternativa el proceso económico.

Quizás la más relevante sea la keynesiana[15], que rechaza la idea de que los mercados se equilibren automáticamente y permitan regresar al pleno empleo; por lo que plantea que los gobiernos deben intervenir en los mercados mediante la política fiscal y no dejarlos a «la mano invisible».

La más profunda quizás sea la teoría marxista[16], que critica a la neoclásica por ignorar el conflicto de clases y la explotación de la fuerza de trabajo, ya que de ésta proviene el valor, no de una utilidad subjetiva. Explica el proceso económico por la dinámica de las relaciones de poder entre el capital y el trabajo, en lugar de un supuesto intercambio mutuamente beneficioso.

La economía conductual[17], crítica psicológica que rechaza la suposición de la racionalidad perfecta, porque los seres humanos reales no son robots calculadores, sino individuos con emociones y preferencias, que no siempre toman las mejores decisiones para su interés económico.

La economía institucional critica a la neoclásica por considerar el mercado como una abstracción matemática que existe en el vacío. Explica cómo los derechos de propiedad, las regulaciones y las estructuras de gobernanza afectan la gestión medioambiental. Uno de sus principales representantes, Elinor Oström (1990), demuestra que a cierta escala de población y territorio la gestión de recursos naturales funciona bajo formas de propiedad colectiva. Es decir, reconoce el problema de la «tragedia de los comunes» (Hardin, G. 1968) como una falla institucional a escala de países o regiones.

Y por supuesto, la economía ecológica, desarrollada principalmente por Robert Costanza[18] y Herman Daly[19], discípulos de Nicholas Georgescu-Roegen, así como el ecólogo Howard T. Odum[20] y el economista Joan Martínez Alier[21]. En 1989 se fundó la Sociedad Internacional de Economía Ecológica[22]. Su crítica central es que la economía es un subsistema de la biosfera, por lo que el crecimiento infinito es imposible. Actualmente, la mayor parte de sus promotores realizan economía ambiental y economía política, muy pocos realizan realmente investigación ecológica de la economía, es decir, estudios sobre el flujo de energía y materiales en la economía, sobre el metabolismo socio-industrial.

En lo que sigue se presenta una descripción de la teoría económica neoclásica, para dar lugar, después, a la crítica de Nicholas Georgescu-Roegen: entropía y proceso económico.

Microeconomía

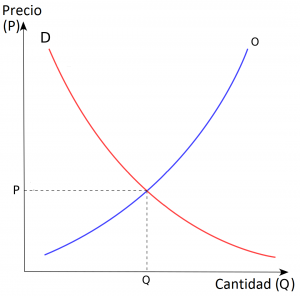

La microeconomía estudia las decisiones de los actores individuales —hogares y empresas— y sus interacciones en los mercados. Utiliza el modelo de oferta y demanda para determinar cómo se establecen los precios y la cantidad de bienes y servicios, que pueden encontrar un punto de equilibrio cuando la demanda y la oferta coinciden y el precio de mercado se estabiliza. De donde se supone una capacidad reguladora de los mercados.

Figura 41. Diagrama del modelo de la oferta y la demanda.

Fuente: https://www.socioeco.org/bdf_auteur-1737_fr.html

Macroeconomía

Por su parte, la macroeconomía estudia la economía en su conjunto, a escala de país o región, considerando tres indicadores claves: el producto interno bruto (PIB), valor total de todos los bienes y servicios finales producidos durante un periodo dado; la inflación; y el desempleo. Asimismo, analiza las decisiones de política presupuestaria de los gobiernos y de política monetaria de los bancos centrales en su intención por lograr un crecimiento estable, control de la inflación y bajas tasas de desempleo.

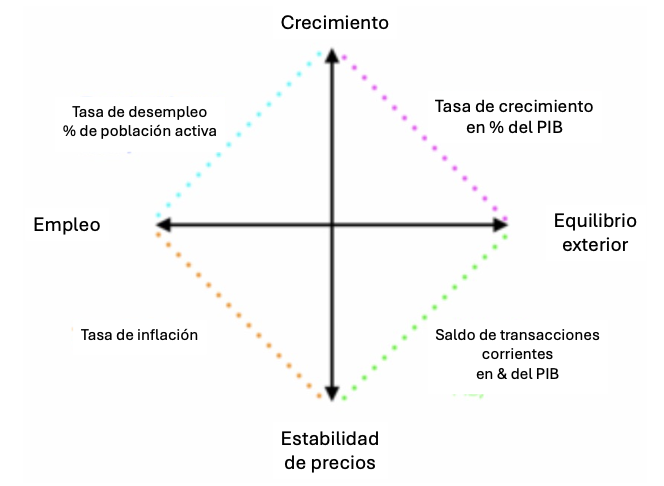

Figura 42. Diagrama del «cuadrado mágico» de Kaldor.

Fuente: Con base en Piaser, G. 2024.

Bajo el supuesto de que el objetivo central de la macroeconomía es el de asegurar la prosperidad económica de un país o región, analiza las cuatro grandes variables de la macroeconomía keynesiana: crecimiento, empleo, precios y comercio exterior. Para lo cual utiliza el concepto del «cuadrado mágico»; calificado de mágico porque en la realidad es prácticamente imposible alcanzar simultáneamente los cuatro objetivos (Figura 42); lo que generalmente sucede es un conflicto entre ellos. Por ejemplo, un fuerte crecimiento sobrecalienta la economía y genera inflación, obligando a que las autoridades políticas arbitren entre uno y otro.

La macroeconomía mantiene el objetivo del crecimiento porque supone que es la única manera de crear riqueza y, así, crear empleos, mejorar el nivel de vida de los habitantes y generar ingresos fiscales para el Estado —a fin de financiar los servicios públicos a los que está obligado (salud, educación, etc.). El objetivo del pleno empleo es esencial para que todos los ciudadanos tengan ingresos, así como evitar la pobreza y los problemas sociales que de ella derivan. El objetivo de la estabilidad de precios es necesario para controlar la inflación, con lo que se evita que el poder de compra se erosione o que se desincentive la inversión. Y el objetivo de equilibrio del comercio exterior se requiere para evitar déficits comerciales estructurales que incrementen la deuda externa.

Pero como se mencionó más arriba, en la práctica es irrealizable alcanzar los cuatro objetivos simultáneamente. Porque, por ejemplo, si para reducir el desempleo el gobierno incrementa el gasto público, con ello puede aumentar la inflación, así como la deuda pública para las generaciones futuras. O bien, aunque un crecimiento económico fuerte incita a incrementar el consumo, ello puede generar un aumento de las importaciones y desequilibrar la balanza del comercio exterior.

Por añadidura, hoy día se ha vuelto de actualidad un quinto objetivo: la sostenibilidad ambiental, que actualmente se aborda bajo el enfoque del «crecimiento verde», un crecimiento que respete la integridad ambiental, que desacople el crecimiento de la contaminación y el agotamiento de recursos naturales y que administre la transición climática y la transición energética.

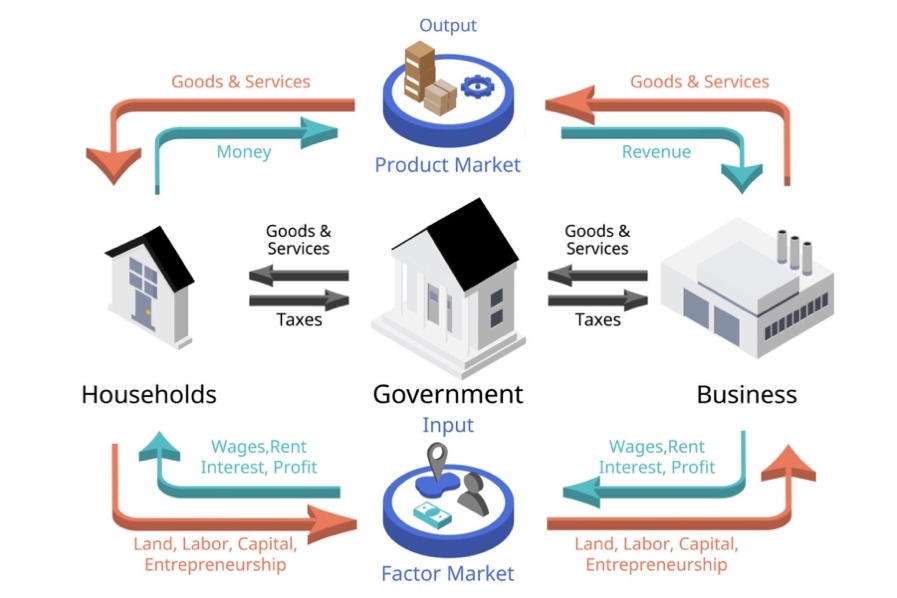

El modelo de flujo circular

El proceso económico se describe conteniendo tres actividades básicas: producción, distribución y consumo. La producción es la parte del proceso que crea los bienes y servicios; e involucra la combinación de los factores de la producción (trabajo, tierra, capital y capacidad emprendedora). La distribución es la forma en que los bienes y servicios producidos se dividen y entregan a diferentes personas o empresas. Y el consumo, objetivo último de toda actividad económica, es la etapa en la que las personas o grupos utilizan los bienes y servicios para satisfacer sus necesidades y deseos.

Figura 43. Modelo de Flujo Circular, concepto fundacional de la teoría económica.

Fuente: https://kids.britannica.com/students/article/economics/274118/media?assemblyId=167503

La manera típica de describir el proceso económico es mediante el modelo de flujo circular, concepto fundacional de la teoría económica, especialmente en macroeconomía. Este modelo muestra que una economía industrial moderna consiste en un flujo circular de bienes, servicios y dinero. La mano de obra, la tierra o el capital fluyen hacia las empresas para producir bienes o servicios. El dinero fluye de las empresas hacia los individuos en forma de salarios, rentas y beneficios. Gran parte de ese dinero vuelve a las empresas con la compra de productos o servicios. Y el valor total de todos los bienes y servicios de una economía se mide como producto nacional bruto (PNB).

El modelo de producción agregada

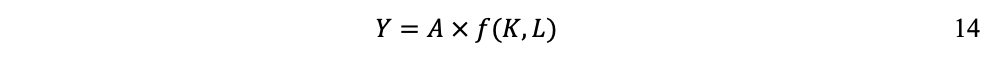

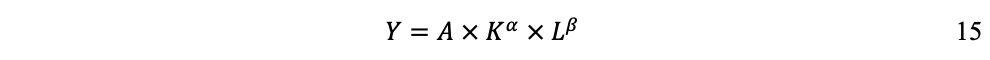

Por otra parte, el modelo de producción agregada explica cómo se realiza el proceso económico (Solow, R.M., 1957). Este modelo cuantifica los insumos de entrada al sistema económico —los factores de producción— y cómo se transforman en productos de salida, mediante la ecuación:

Donde Y, producto total (PIB), es una función de K, el stock de capital (el capital construido), L, la cantidad disponible de fuerza de trabajo y A, la componente tecnológica, que expresa el nivel de productividad global de los factores de producción.

El modelo del flujo circular (Figura 43) ilustra que los hogares e individuos ofrecen a las empresas los factores de la producción trabajo (L) y capital (K) (vía ahorros que financian la inversión). Con los cuales, más la tecnología disponible (A), las empresas producen los bienes y servicios (Y). El ingreso de los hogares e individuos proviene del pago de las empresas a los factores de producción. En el marco de la teoría neoclásica, la función de producción permite determinar el valor total de lo producido (Y), que se cuantifica mediante el PIB.

Generalmente, se utiliza la ecuación 14 con la formulación Cobb-Douglas[23]:

Donde a expresa la contribución del capital (K) y b la contribución del trabajo (L), considerando que a + ß = 1.

Por ejemplo, sabiendo que en los países desarrollados generalmente se estima que y , si se cuantifica un crecimiento de 5% del PIB, un incremento de 6% de K y un incremento de 2% de L; la contribución de K será 1.8% y la contribución de L será 1.4%; sumando una contribución total de 3.2% por parte de los factores de producción. ¿Dónde queda el 1.8% restante del crecimiento? Se adjudica al mejoramiento tecnológico, a la productividad global de los factores de la producción, o residuo de Solow (Solow, R.M. 1957).

…

Entropía del proceso económico

Antecedentes

Otros economistas (Ayres, R.U. & Warr, B. 2010), señalan que el residuo de Solow es la exergía, o fracción útil de cada joule invertido en el proceso productivo. Y muestran que la combinación de los factores capital (K) y trabajo (L) con el factor trabajo físico realizado por las máquinas —cuantificado como exergía[24] movilizada en el proceso de producción— explica casi la totalidad del crecimiento económico observado desde 1900 en los Estados Unidos y otros países desarrollados (Ayres, R.U. et al, 2003). Robert Ayres se cuenta entre los principales promotores de introducir la dimensión termodinámica en el proceso económico.

Pero fue Nicholas Georgescu-Roegen quien realizó, a partir de los años 1960, la crítica termodinámica fundamental a la teoría neoclásica de la economía. La crítica de Georgescu-Roegen constituye uno de los mayores desafíos de la teoría económica ortodoxa. Porque mientras que la corriente principal del pensamiento económico ha ignorado su obra, la actual preocupación por la creciente crisis ecológica planetaria reconoce su relevancia. Porque su mensaje central es que la economía debe reconocer que es un subsistema dentro de un sistema biofísico —la biosfera— gobernado por las leyes de la termodinámica. Porque hoy día la disyuntiva de la política económica es si prioriza la sostenibilidad y la viabilidad de largo plazo del desarrollo humano, o mantiene un crecimiento indefinido y una sociedad de consumo de corto plazo.

Nicholas Georgescu-Roegen

Nicholas Georgescu-Roegen (NGR) nació un domingo 4 de febrero de 1906, en Constanza, Rumania y murió el domingo 30 de octubre de 1994, en Nashville, Tennessee, USA. Desarrolló una de las más profundas críticas a la teoría económica neoclásica; la más importante desde el punto de vista de la ecología[25]. Su obra creó las bases para el desarrollo de la economía ecológica y el movimiento a favor del decrecimiento. NGR es, sin duda, el más importante economista ecológico del siglo XX; y será —eso esperamos, apostamos a ello— plenamente reconocido en el curso del siglo XXI, conforme avance la transgresión de umbrales planetarios y la humanidad se vea obligada a reaccionar y ajustarse, finalmente, a los límites biofísicos que impone la biosfera.

La obra de NGR es interdisciplinaria (NGR, 1971). Puso a prueba la teoría económica con las leyes de la termodinámica y la dimensión biológica de la sociedad. Consideraba que la economía es en realidad una extensión de la evolución de Homo sapiens porque, a diferencia de los demás seres vivos, cuyos órganos son solamente endosomáticos —resultado de su evolución biológica—, el ser humano ha desarrollado órganos exosomáticos —resultado de su evolución tecnológica (NGR, 2013). Gracias a lo cual nos es posible cocinar, respirar bajo el agua, volar, trasladarse más rápido que un caballo y producir bienes y servicios en cantidades colosales. Quizás por eso abundan quienes creen que podemos continuar nuestra existencia violando leyes biofísicas.

Matemático de formación original, NGR fue un economista heterodoxo y, finalmente, un disidente, muy incómodo. Porque nadie podía enfrentarlo en el terreno de la econometría y, menos aún, en el terreno de la dimensión termodinámica del proceso económico (Carpintero, O., 2006). Proceso que la teoría económica supone circular y reversible, pero que en realidad es un proceso irreversible sujeto a la ley de la entropía.

Este es el argumento central de NGR, el proceso económico es fundamentalmente entrópico, porque, además de transformar recursos de baja entropía (energía y materiales utilizables) en bienes y servicios, simultáneamente los transforma también en desechos (calor residual, desechos, emisiones, contaminación) de alta entropía. Lo cual contradice la suposición central neoclásica del modelo de flujo circular y del crecimiento perpetuo. Por consiguiente, a largo plazo el crecimiento económico continuo es físicamente imposible, porque los recursos de la Tierra de baja entropía son finitos y nunca podrán reciclarse al 100%.

NGR subraya que la economía neoclásica considera el proceso productivo como si fuera un sistema mecánico en equilibrio, utilizando modelos económicos que suponen que los procesos son reversibles, no obstante que la terca realidad demuestre lo contario. Por ejemplo, los combustibles fósiles no pueden recuperarse una vez quemados; las especies extintas son irrecuperables.

En particular, desafía la función de producción, enfatizando que los recursos naturales los subsume en el factor capital (K), o bien los trata como entrantes opcionales, cuando en realidad constituyen la base material de toda producción. Asimismo, por la suposición de que el capital (K) pueda sustituir indefinidamente recursos naturales, lo cual viola leyes físicas. No se puede hacer un pastel solamente con trabajo y equipo de cocina, se necesitan recursos naturales, trigo y energía.

Como alternativa al enfoque de la teoría económica neoclásica, NGR propone un enfoque bioeconómico[26], que reconoce a los seres humanos como entidades biológicas y al proceso económico como extensión de la evolución de Homo sapiens, sujeto a las leyes de la termodinámica. Así, NGR distingue entre factores de fondo: capital (K) y trabajo (L); y factores de flujo: recursos naturales, materiales y energía, que son físicamente transformados y disipados en el proceso económico.

El modelo de flujos-fondos

A diferencia de la función de producción neoclásica, que trata todos los insumos como factores homogéneos que solo difieren en cantidad, el modelo de flujos y fondos reconoce que los insumos desempeñan funciones cualitativamente diferentes en la producción (NGR, 1971, ch. 9). Esta distinción no es solamente semántica o clasificatoria, sino que refleja realidades físicas y termodinámicas que tienen profundas implicaciones para la teoría económica, la gestión de recursos y la sostenibilidad.

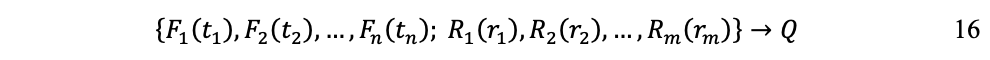

La idea central del modelo parece simple pero es profunda: no todos los factores de la producción son iguales. Difieren en cantidad o productividad marginal, pero también en su naturaleza y función dentro del proceso de producción. De donde NGR identifica dos categorías de factores[27]: elementos de fondo Fi (donde i =1, 2, 3…, n), que representan a los agentes del proceso; y elementos de flujo Rj (donde j = 1, 2, 3… m), que son los utilizados o aplicados por los agentes.

Los elementos de fondo existen al inicio del proceso de producción y siguen existiendo al final. Por ejemplo: la fuerza humana de trabajo (L); el capital (K) (maquinaria, herramientas, inmuebles, infraestructuras); o la tierra, como ubicación o plataforma.

Los elementos de flujo, entran al proceso y una parte pasa a formar parte del producto, en tanto que otra parte se degrada y se convierte en desechos o se disipa. Por ejemplo: materias primas (metales, madera, químicos); bienes intermedios de otros procesos de producción; y energía (combustibles, electricidad). Notablemente, los servicios ambientales (polinización, regulación climática, ciclos de nutrientes, asimilación de contaminación) también son elementos de flujo.

Esta distinción refleja las características físicas y temporales de cómo los diferentes insumos participan en la producción. Una máquina (fondo) puede producir muchas unidades a lo largo de su vida útil; la gasolina (flujo) se consume en un sólo uso. Un trabajador (fondo) vende servicios laborales, pero sigue siendo un agente independiente; el mineral de hierro (flujo) se transforma en la producción de acero.

A diferencia de los fondos, los flujos sufren una transformación física irreversible durante el proceso productivo. Esta transformación no es solo un cambio de propietario o ubicación (como suele suponer implícitamente la teoría neoclásica), sino una auténtica reconfiguración física y química: entran en el proceso de producción de una forma y salen de otra, ya sea como parte del producto o como residuo.

Los fondos prestan servicios medidos en unidades de tiempo (horas máquina, días de trabajo); en cambio, los flujos se miden en cantidades físicas: toneladas, litros, kilovatios hora, metros cúbicos (no se alquila carbón por horas, se consumen cantidades específicas). Además, los flujos suelen ser altamente divisibles —se pueden utilizar 150.7 toneladas de cemento, 425.3 kilovatios-hora de electricidad o 395.8 litros de amoniaco. Variabilidad que contrasta con la naturaleza discreta e indivisible de los fondos.

NGR subraya el carácter de rendimiento de los flujos, que fluyen a través del proceso de producción: entran, se transforman y salen. Este movimiento direccional es irreversible y difiere totalmente del carácter circular y reversible que los modelos neoclásicos atribuyen a los procesos económicos. El carácter de rendimiento de los flujos demuestra que el proceso de producción utiliza necesariamente recursos naturales de baja entropía y genera desechos de alta entropía. No es posible reciclar los flujos para devolverlos a su estado original sin gastar energía adicional y generar residuos adicionales; y la energía disipada es irrecuperable.

Por lo demás, NGR demuestra que la hipótesis neoclásica de la sustitución de factores es, en gran medida, ilusoria. Los fondos y los flujos se complementan entre sí: el capital (K) o la fuerza de trabajo (L) no pueden producir sin energía y sin materiales; no puede haber sustitutos tecnológicos para todo recurso natural, porque no es posible transformar completamente fondos en flujos.

Ecuación del modelo de flujos-fondos

El proceso de producción en el modelo de flujos-fondos se caracteriza por:

- tener una duración td, periodo de tiempo de un ciclo de producción

- cada fondo Fi provee servicios por un tiempo ti < or = td

- cada flujo Rj requiere una cantidad de entrada rⱼ consumida durante el proceso.

De tal modo que el proceso de producción puede formularse como:

Es decir, cada fondo, del F1 al Fn , provee servicios de duración t1 hasta tn ; cada flujo, del R1 al Rm , es consumido en cantidades r1 hasta rm ; y el resultado es la cantidad producida Q.

Además, cada fondo impone límites de capacidad ki x sigmai al servicio requerido; donde ki es el número de unidades de cada fondo Fi y sigmai es la capacidad de servicio de cada unidad de fondo Fi por período de tiempo. Asimismo, cada fondo impone límites temporales, ya que solo puede prestar servicios hasta su capacidad máxima durante el tiempo disponible. Por ejemplo, si una fábrica posee siete máquinas (k = 7), cada una con capacidad de operar catorce horas diarias (sigma = 14 hrs/día), la capacidad total de servicio es de 98 máquinas-horas por día.

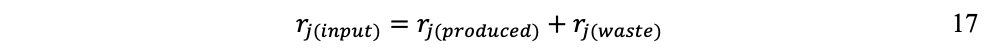

Para cada flujo se incorpora una ecuación de equilibrio que refleje la primera ley de la termodinámica (conservación de la masa/energía). Para el flujo de materiales:

Lo que significa que todo material de entrada debe contabilizarse no solamente como producto de salida, sino también su fracción de desecho.

Para el flujo de energía:

Donde es la exergía, lo que implica que de toda energía de entrada (de baja entropía) debe contabilizarse la fracción disipada (de alta entropía), perdida en el proceso.

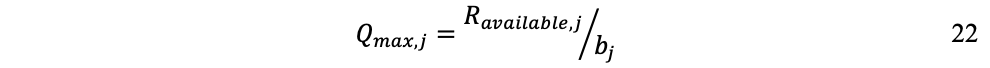

La ecuación 16 también involucra coeficientes tecnológicos. Por una parte, coeficientes ai de salida de los fondos:

Lo que expresa que para producir Q unidades se necesita utilizar el fondo Fi durante un tiempo ti.

Por otra parte, coeficientes bj de salida de los flujos:

Lo que refleja la cantidad rj de materia y energía necesaria por cada unidad producida.

Estos coeficientes suelen establecerse por cada tecnología y a corto plazo. Porque, por ejemplo, no se puede variar fácilmente la cantidad de acero necesaria para cada unidad automotriz producida, o el tiempo de máquina requerido por unidad, ya que están determinados por las especificaciones técnicas.

Una vez establecidos coeficientes tecnológicos y límites de capacidad de los fondos, el máximo nivel de producción puede formularse; para la producción límite de fondos:

Donde T es el período planificado y la producción máxima está limitada por la capacidad del fondo Fi.

Y para la producción límite de flujos:

Donde la producción máxima está limitada por los flujos Rj disponibles.

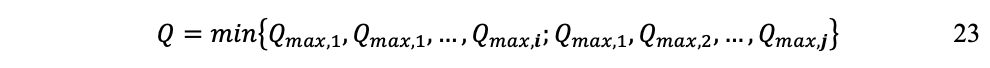

Finalmente, la producción real puede expresarse como:

Lo que expresa que la producción estará limitada por el recurso más escaso; cualquier flujo o fondo puede imponer esta restricción.

Longevidad industrial de Homo sapiens

Ya desde los inicios del pensamiento económico, algunos economistas (Smith, Ricardo, J.S. Mill) postularon el concepto de estado estacionario de una economía (Uçak, A., 2013) previendo que, tarde o temprano, todas se estabilizarían en un estado final estacionario, caracterizado por un stock constante de riqueza física (capital) y una población de tamaño constante.

Y desde la década de 1970 el concepto de estado estacionario quedó asociado principalmente con el destacado economista ecológico Herman Daly (1980 & 1991 [1977]), quien incorporó la dimensión ecológica de los flujos de recursos naturales a través de la economía.

Pero NGR, con su estricto espíritu científico, explicó por qué alcanzar una economía en estado estacionario no resolvería —más que transitoriamente— el problema de fondo de la sostenibilidad a largo plazo, a propósito de lo cual presenta un relevante teorema sobre el límite temporal de supervivencia del Homo sapiens industrial (NGR 2011b, p. 126).

Los recursos naturales de flujo RNf son los que provienen directamente de la energía solar, la fotosíntesis (biomasa), o solar más gravedad (hidráulica, eólica). Los recursos naturales de stock RNs provienen indirectamente de la energía solar (combustibles fósiles); y de la formación geológica e historia de la Tierra (minerales, metales, geotermia, nuclear).

Los RNf son, en principio, inagotables porque son renovables (siempre y cuando sus capacidades regenerativas no sean transgredidas por Homo sapiens). En cambio, los RNs son finitos y, tarde o temprano, se agotarán: Por ello, fundar la civilización de Homo sapiens sobre estos recursos ―en lugar de los RNf ―, va en sentido contrario a la viabilidad de largo plazo de las generaciones futuras aunque, por supuesto, satisfaga egoístamente los intereses de corto plazo de las generaciones actuales.

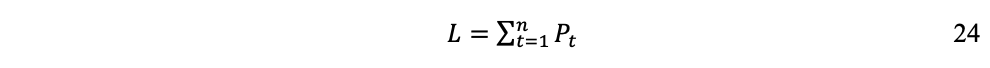

Si consideramos S el stock total de RNs (lo que NGR denomina «la dote» de la humanidad), Pt la población humana en el tiempo y st la fracción de S utilizada por habitante por año, tenemos que la longevidad L de la civilización industrial es:

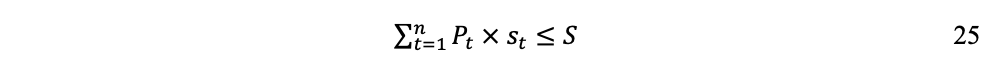

Donde S constituye el límite superior para L por la restricción:

Para un tiempo tlim > n, cuando la utilización acumulada de las fracciones st hayan agotado el stock finito S, la sumatoria será:

Y por consiguiente:

Este tiempo límite tlim corresponde a la longevidad L de la población humana en las condiciones de su civilización industrial, una vez agotados los recursos naturales de stock RNs. Resulta evidente que a mayor tasa de extracción y utilización de st (flujo de materiales, sección 1.5), más rápidamente llegaremos a tlim y menor será L.

Más allá de las propuestas de «economía estacionaria» (Daly H.E. 1980 & 1991 [1977]), una cuestión clave se desprende del pensamiento de NGR: para que la probabilidad de extinción[28] de Homo sapiens se mantenga suficientemente cercana a cero (o, al menos, lejana de 1) es indispensable que, en algún momento del futuro previsible, la economía humana restablezca sus soportes económicos sobre los RNf y no los RNs. Lo cual implica mucho más de lo que hoy se plantea como «desacoplamiento»[29] del crecimiento económico respecto del agotamiento de recursos naturales.

El ensayo completo sobre «Límites del crecimiento y termodinámica del proceso económico» se encuentra en:

https://www.glocalfilia.com/Biblio/Entropy&Growth/2026_GrowthLim_PBS_Entropy.pdf

[1] Se entiende que el sol, nuestra estrella amarilla, se encuentra a la mitad de su vida y, dentro de 5 mil millones de años pasará a ser gigante roja antes de colapsar. La predicción de la termodinámica sobre la muerte térmica del universo es mucho más lejana en el tiempo, inconmensurable.

[2] https://www.marxists.org/espanol/m-e/1870s/gotha/critica-al-programa-de-gotha.htm

[3] Lo que Nicholas Georgescu-Roegen denomina la «dote» de bienes terrenales que recibe el ser humano de la naturaleza (ver más adelante).

[4] https://www.vedantu.com/physics/relation-between-work-and-energy

[5] https://www.eia.gov/energyexplained/what-is-energy/forms-of-energy.php

[6] Un Newton es la fuerza capaz de acelerar un objeto de masa 1 kilogramo, incrementando cada segundo su velocidad de un metro por segundo (1kg x 1m/s/s); en tanto que un Joule es la cantidad de trabajo realizado cuando una fuerza de 1 Newton desplaza un objeto a un metro de distancia (1kg x 1m/s2) x (1m).

[8] Por oposición a nuestros órganos biológicos, que se modifican por selección natural, los artefactos creados por el ser humano son «órganos»exosomáticos que amplifican nuestras capacidades biológicas. Por ejemplo, estufas para cocinar, aviones para volar, automóviles para desplazarnos a gran velocidad, equipos de buceo para respirar bajo el agua; y, en general, todas las herramientas, máquinas e infraestructuras.

[9] Una caloría es la cantidad de energía necesaria para elevar la temperatura de 1 gramo de agua 1 Centígrado.

[10] https://www.britannica.com/biography/Antoine-Lavoisier

[11] Es convención generalizada el uso de mayúsculas para las cantidades termodinámicas que son funciones de estado (E, T, V, P y S); en tanto que se utilizan minúsculas para los parámetros de transferencia de energía (q y w).

[12] https://www.france-memoire.fr/dossiers/reflexion-sur-la-puissance-motrice-du-feu-de-sadi-carnot/

[13] https://www.britannica.com/science/entropy-physics

[14] https://www.britannica.com/topic/economic-theory

[15] https://www.britannica.com/money/John-Maynard-Keynes

[16] https://www.britannica.com/biography/Karl-Marx

[17] https://www.britannica.com/topic/behavioral-economics

[18] https://www.robertcostanza.com

[19] https://steadystate.org/herman-daly/

[20] https://www.emergysociety.com/howard-t-odum/

[21] https://www.socioeco.org/bdf_auteur-1737_fr.html

[22] International Society of Ecological Economics: https://www.isecoeco.org

[23] https://www.britannica.com/topic/Cobb-Douglas-function

[24] Máximo trabajo útil que se puede extraer de un sistema a medida que alcanza un equilibrio reversible con su entorno. En pocas palabras: capacidad de cierto tipo de energía para realizar un trabajo. https://exergyeconomics.wordpress.com/exergy-economics-101/what-is-exergy/

[25] https://www.universalis.fr/recherche/nicholas%20georgescu-roegen/article/1/

[26] La vida no le dio suficiente tiempo a NGR para concluir su proyecto de publicar un tratado completo de bioeconomía, pero dejó algunos artículos y notas de conferencias que permiten hacerse una idea de la construcción teórica que deseaba concretar. (Véase en la Bibliografía).

[27] Georgescu-Roegen, N. 1971. The Entropy Law and the Economic Process. Cambridge, Mass. Harvard Univ. Press, pp 230 y siguientes. https://archive.org/details/entropylawe00nich

[28] https://www.sciencedirect.com/topics/mathematics/extinction-probability

[29] En economía ambiental, el «desacoplamiento» se refiere a la posibilidad de crecer sin el correspondiente incremento de la degradación ambiental (UNEP, 2011; UNEP, 2024; OECD, 2011).

WHAT IS THERMODYNAMICS

from encyclopaedia Britannica

https://www.britannica.com/science/thermodynamics/Entropy-and-heat-death

Thermodynamics is the science of the relationship between heat, work, temperature, and energy. In broad terms, thermodynamics deals with the transfer of energy from one place to another and from one form to another. The key concept is that heat is a form of energy corresponding to a definite amount of mechanical work.

Heat was not formally recognized as a form of energy until about 1798, when Count Rumford (Sir Benjamin Thompson), a British military engineer, noticed that limitless amounts of heat could be generated in the boring of cannon barrels and that the amount of heat generated is proportional to the work done in turning a blunt boring tool. Rumford’s observation of the proportionality between heat generated and work done lies at the foundation of thermodynamics. Another pioneer was the French military engineer Sadi Carnot, who introduced the concept of the heat-engine cycle and the principle of reversibility in 1824. Carnot’s work concerned the limitations on the maximum amount of work that can be obtained from a steam engine operating with a high-temperature heat transfer as its driving force. Later that century, these ideas were developed by Rudolf Clausius, a German mathematician and physicist, into the first and second laws of thermodynamics, respectively.

The most important laws of thermodynamics are:

- The zeroth law of thermodynamics. When two systems are each in thermal equilibrium with a third system, the first two systems are in thermal equilibriumwith each other. This property makes it meaningful to use thermometers as the “third system” and to define a temperature scale.

- The first law of thermodynamics, or the law of conservation of energy. The change in a system’s internal energy is equal to the difference between heat added to the system from its surroundings and work done by the system on its surroundings.

- The second law of thermodynamics. Heat does not flow spontaneously from a colder region to a hotter region, or, equivalently, heat at a given temperature cannot be converted entirely into work. Consequently, the entropy of a closed system, or heat energy per unit temperature, increases over time toward some maximum value. Thus, all closed systems tend toward an equilibrium state in which entropy is at a maximum and no energy is available to do useful work.

- The third law of thermodynamics. The entropy of a perfect crystal of an element in its most stable form tends to zero as the temperature approaches absolute zero. This allows an absolute scale for entropy to be established that, from a statistical point of view, determines the degree of randomness or disorder in a system.

Although thermodynamics developed rapidly during the 19th century in response to the need to optimize the performance of steam engines, the sweeping generality of the laws of thermodynamics makes them applicable to all physical and biological systems. In particular, the laws of thermodynamics give a complete description of all changes in the energy state of any system and its ability to perform useful work on its surroundings.

This article covers classical thermodynamics, which does not involve the consideration of individual atoms or molecules. Such concerns are the focus of the branch of thermodynamics known as statistical thermodynamics, or statistical mechanics, which expresses macroscopic thermodynamic properties in terms of the behaviour of individual particles and their interactions. It has its roots in the latter part of the 19th century, when atomic and molecular theories of matter began to be generally accepted.

Fundamental concepts

Thermodynamic states

The application of thermodynamic principles begins by defining a system that is in some sense distinct from its surroundings. For example, the system could be a sample of gasinside a cylinder with a movable piston, an entire steam engine, a marathon runner, the planet Earth, a neutron star, a black hole, or even the entire universe. In general, systems are free to exchange heat, work, and other forms of energy with their surroundings.

A system’s condition at any given time is called its thermodynamic state. For a gas in a cylinder with a movable piston, the state of the system is identified by the temperature, pressure, and volume of the gas. These properties are characteristic parameters that have definite values at each state and are independent of the way in which the system arrived at that state. In other words, any change in value of a property depends only on the initial and final states of the system, not on the path followed by the system from one state to another. Such properties are called state functions. In contrast, the work done as the piston moves and the gas expands and the heat the gas absorbs from its surroundings depend on the detailed way in which the expansion occurs.

The behaviour of a complex thermodynamic system, such as Earth’s atmosphere, can be understood by first applying the principles of states and properties to its component parts—in this case, water, water vapour, and the various gases making up the atmosphere. By isolating samples of material whose states and properties can be controlled and manipulated, properties and their interrelations can be studied as the system changes from state to state.

Thermodynamic equilibrium

A particularly important concept is thermodynamic equilibrium, in which there is no tendency for the state of a system to change spontaneously. For example, the gas in a cylinder with a movable piston will be at equilibrium if the temperature and pressure inside are uniform and if the restraining force on the piston is just sufficient to keep it from moving. The system can then be made to change to a new state only by an externally imposed change in one of the state functions, such as the temperature by adding heat or the volume by moving the piston. A sequence of one or more such steps connecting different states of the system is called a process. In general, a system is not in equilibrium as it adjusts to an abrupt change in its environment. For example, when a balloon bursts, the compressed gas inside is suddenly far from equilibrium, and it rapidly expands until it reaches a new equilibrium state. However, the same final state could be achieved by placing the same compressed gas in a cylinder with a movable piston and applying a sequence of many small increments in volume (and temperature), with the system being given time to come to equilibrium after each small increment. Such a process is said to be reversible because the system is at (or near) equilibrium at each step along its path, and the direction of change could be reversed at any point. This example illustrates how two different paths can connect the same initial and final states. The first is irreversible (the balloon bursts), and the second is reversible. The concept of reversible processes is something like motion without friction in mechanics. It represents an idealized limiting case that is very useful in discussing the properties of real systems. Many of the results of thermodynamics are derived from the properties of reversible processes.

Temperature

The concept of temperature is fundamental to any discussion of thermodynamics, but its precise definition is not a simple matter. For example, a steel rod feels colder than a wooden rod at room temperature simply because steel is better at conducting heat away from the skin. It is therefore necessary to have an objective way of measuring temperature. In general, when two objects are brought into thermal contact, heat will flow between them until they come into equilibrium with each other. When the flow of heat stops, they are said to be at the same temperature. The zeroth law of thermodynamics formalizes this by asserting that if an object A is in simultaneous thermal equilibrium with two other objects B and C, then B and C will be in thermal equilibrium with each other if brought into thermal contact. Object A can then play the role of a thermometer through some change in its physical properties with temperature, such as its volume or its electrical resistance.

With the definition of equality of temperature in hand, it is possible to establish a temperature scale by assigning numerical values to certain easily reproducible fixed points. For example, in the Celsius (°C) temperature scale, the freezing point of pure water is arbitrarily assigned a temperature of 0 °C and the boiling point of water the value of 100 °C (in both cases at 1 standard atmosphere; see atmospheric pressure). In the Fahrenheit (°F) temperature scale, these same two points are assigned the values 32 °F and 212 °F, respectively. There are absolute temperature scales related to the second law of thermodynamics. The absolute scale related to the Celsius scale is called the Kelvin (K) scale, and that related to the Fahrenheit scale is called the Rankine (°R) scale. These scales are related by the equations K = °C + 273.15, °R = °F + 459.67, and °R = 1.8 K. Zero in both the Kelvin and Rankine scales is at absolute zero.

Work and energy

Energy has a precise meaning in physics that does not always correspond to everyday language, and yet a precise definition is somewhat elusive. The word is derived from the Greek word ergon, meaning work, but the term work itself acquired a technical meaning with the advent of Newtonian mechanics. For example, a man pushing on a car may feel that he is doing a lot of work, but no work is actually done unless the car moves. The work done is then the product of the force applied by the man multiplied by the distance through which the car moves. If there is no friction and the surface is level, then the car, once set in motion, will continue rolling indefinitely with constant speed. The rolling car has something that a stationary car does not have—it has kinetic energy of motion equal to the work required to achieve that state of motion. The introduction of the concept of energy in this way is of great value in mechanics because, in the absence of friction, energy is never lost from the system, although it can be converted from one form to another. For example, if a coasting car comes to a hill, it will roll some distance up the hill before coming to a temporary stop. At that moment its kinetic energy of motion has been converted into its potential energy of position, which is equal to the work required to lift the car through the same vertical distance. After coming to a stop, the car will then begin rolling back down the hill until it has completely recovered its kinetic energy of motion at the bottom. In the absence of friction, such systems are said to be conservative because at any given moment the total amount of energy (kinetic plus potential) remains equal to the initial work done to set the system in motion.

As the science of physics expanded to cover an ever-wider range of phenomena, it became necessary to include additional forms of energy in order to keep the total amount of energy constant for all closed systems (or to account for changes in total energy for open systems). For example, if work is done to accelerate charged particles, then some of the resultant energy will be stored in the form of electromagnetic fields and carried away from the system as radiation. In turn the electromagnetic energy can be picked up by a remote receiver (antenna) and converted back into an equivalent amount of work. With his theory of special relativity, Albert Einstein realized that energy (E) can also be stored as mass (m) and converted back into energy, as expressed by his famous equation E = mc2, where c is the velocity of light. All of these systems are said to be conservative in the sense that energy can be freely converted from one form to another without limit. Each fundamental advance of physics into new realms has involved a similar extension to the list of the different forms of energy. In addition to preserving the first law of thermodynamics (see below), also called the law of conservation of energy, each form of energy can be related back to an equivalent amount of work required to set the system into motion.

Thermodynamics encompasses all of these forms of energy, with the further addition of heat to the list of different kinds of energy. However, heat is fundamentally different from the others in that the conversion of work (or other forms of energy) into heat is not completely reversible, even in principle. In the example of the rolling car, some of the work done to set the car in motion is inevitably lost as heat due to friction, and the car eventually comes to a stop on a level surface. Even if all the generated heat were collected and stored in some fashion, it could never be converted entirely back into mechanical energy of motion. This fundamental limitation is expressed quantitatively by the second law of thermodynamics (see below).

The role of friction in degrading the energy of mechanical systems may seem simple and obvious, but the quantitative connection between heat and work, as first discovered by Count Rumford, played a key role in understanding the operation of steam engines in the 19th century and similarly for all energy-conversion processes today.

Total internal energy

Although classical thermodynamics deals exclusively with the macroscopic properties of materials—such as temperature, pressure, and volume—thermal energy from the addition of heat can be understood at the microscopic level as an increase in the kinetic energy of motion of the molecules making up a substance. For example, gas molecules have translational kinetic energy that is proportional to the temperature of the gas: the molecules can rotate about their centre of mass, and the constituent atoms can vibrate with respect to each other (like masses connected by springs). Additionally, chemical energy is stored in the bonds holding the molecules together, and weaker long-range interactions between the molecules involve yet more energy. The sum total of all these forms of energy constitutes the total internal energy of the substance in a given thermodynamic state. The total energy of a system includes its internal energy plus any other forms of energy, such as kinetic energy due to motion of the system as a whole (e.g., water flowing through a pipe) and gravitational potential energy due to its elevation.

The first law of thermodynamics

The laws of thermodynamics are deceptively simple to state, but they are far-reaching in their consequences. The first law asserts that if heat is recognized as a form of energy, then the total energy of a system plus its surroundings is conserved; in other words, the total energy of the universe remains constant.

The first law is put into action by considering the flow of energy across the boundary separating a system from its surroundings. Consider the classic example of a gas enclosed in a cylinder with a movable piston. The walls of the cylinder act as the boundary separating the gas inside from the world outside, and the movable piston provides a mechanism for the gas to do work by expanding against the force holding the piston (assumed frictionless) in place. If the gas does work W as it expands, and/or absorbs heat Q from its surroundings through the walls of the cylinder, then this corresponds to a net flow of energy W − Q across the boundary to the surroundings. In order to conserve the total energy U, there must be a counterbalancing change ΔU = Q − W (1)in the internal energy of the gas. The first law provides a kind of strict energy accounting system in which the change in the energy account (ΔU) equals the difference between deposits (Q) and withdrawals (W).

There is an important distinction between the quantity ΔU and the related energy quantities Q and W. Since the internal energy U is characterized entirely by the quantities (or parameters) that uniquely determine the state of the system at equilibrium, it is said to be a state function such that any change in energy is determined entirely by the initial (i) and final (f) states of the system: ΔU = Uf − Ui. However, Q and W are not state functions. Just as in the example of a bursting balloon, the gas inside may do no work at all in reaching its final expanded state, or it could do maximum work by expanding inside a cylinder with a movable piston to reach the same final state. All that is required is that the change in energy (ΔU) remain the same. By analogy, the same change in one’s bank account could be achieved by many different combinations of deposits and withdrawals. Thus, Q and W are not state functions, because their values depend on the particular process (or path) connecting the same initial and final states. Just as it is more meaningful to speak of the balance in one’s bank account than its deposit or withdrawal content, it is only meaningful to speak of the internal energy of a system and not its heat or work content.

From a formal mathematical point of view, the incremental change dU in the internal energy is an exact differential (see differential equation), while the corresponding incremental changes d′Q and d′W in heat and work are not, because the definite integralsof these quantities are path-dependent. These concepts can be used to great advantage in a precise mathematical formulation of thermodynamics (see below Thermodynamic properties and relations).

Heat engines

The classic example of a heat engine is a steam engine, although all modern engines follow the same principles. Steam engines operate in a cyclic fashion, with the piston moving up and down once for each cycle. Hot high-pressure steam is admitted to the cylinder in the first half of each cycle, and then it is allowed to escape again in the second half. The overall effect is to take heat Q1 generated by burning a fuel to make steam, convert part of it to do work, and exhaust the remaining heat Q2 to the environment at a lower temperature. The net heat energy absorbed is then Q = Q1 − Q2. Since the engine returns to its initial state, its internal energy U does not change (ΔU = 0). Thus, by the first law of thermodynamics, the work done for each complete cycle must be W = Q1 − Q2. In other words, the work done for each complete cycle is just the difference between the heat Q1 absorbed by the engine at a high temperature and the heat Q2 exhausted at a lower temperature. The power of thermodynamics is that this conclusion is completely independent of the detailed working mechanism of the engine. It relies only on the overall conservation of energy, with heat regarded as a form of energy.

In order to save money on fuel and avoid contaminating the environment with waste heat, engines are designed to maximize the conversion of absorbed heat Q1 into useful work and to minimize the waste heat Q2. The Carnot efficiency (η) of an engine is defined as the ratio W/Q1—i.e., the fraction of Q1 that is converted into work. Since W = Q1 − Q2, the efficiency also can be expressed in the form  (2)

(2)

If there were no waste heat at all, then Q2 = 0 and η = 1, corresponding to 100 percent efficiency. While reducing friction in an engine decreases waste heat, it can never be eliminated; therefore, there is a limit on how small Q2 can be and thus on how large the efficiency can be. This limitation is a fundamental law of nature—in fact, the second law of thermodynamics (see below).

Isothermal and adiabatic processes

Because heat engines may go through a complex sequence of steps, a simplified model is often used to illustrate the principles of thermodynamics. In particular, consider a gas that expands and contracts within a cylinder with a movable piston under a prescribed set of conditions. There are two particularly important sets of conditions. One condition, known as an isothermal expansion, involves keeping the gas at a constant temperature. As the gas does work against the restraining force of the piston, it must absorb heat in order to conserve energy. Otherwise, it would cool as it expands (or conversely heat as it is compressed). This is an example of a process in which the heat absorbed is converted entirely into work with 100 percent efficiency. The process does not violate fundamental limitations on efficiency, however, because a single expansion by itself is not a cyclic process.

The second condition, known as an adiabatic expansion (from the Greek adiabatos, meaning “impassable”), is one in which the cylinder is assumed to be perfectly insulated so that no heat can flow into or out of the cylinder. In this case the gas cools as it expands, because, by the first law, the work done against the restraining force on the piston can only come from the internal energy of the gas. Thus, the change in the internal energy of the gas must be ΔU = −W, as manifested by a decrease in its temperature. The gas cools, even though there is no heat flow, because it is doing work at the expense of its own internal energy. The exact amount of cooling can be calculated from the heat capacity of the gas.

Many natural phenomena are effectively adiabatic because there is insufficient time for significant heat flow to occur. For example, when warm air rises in the atmosphere, it expands and cools as the pressure drops with altitude, but air is a good thermal insulator, and so there is no significant heat flow from the surrounding air. In this case the surrounding air plays the roles of both the insulated cylinder walls and the movable piston. The warm air does work against the pressure provided by the surrounding air as it expands, and so its temperature must drop. A more-detailed analysis of this adiabatic expansion explains most of the decrease of temperature with altitude, accounting for the familiar fact that it is colder at the top of a mountain than at its base.

The second law of thermodynamics

The first law of thermodynamics asserts that energy must be conserved in any process involving the exchange of heat and work between a system and its surroundings. A machine that violated the first law would be called a perpetual motion machine of the first kind because it would manufacture its own energy out of nothing and thereby run forever. Such a machine would be impossible even in theory. However, this impossibility would not prevent the construction of a machine that could extract essentially limitless amounts of heat from its surroundings (earth, air, and sea) and convert it entirely into work. Although such a hypothetical machine would not violate conservation of energy, the total failure of inventors to build such a machine, known as a perpetual motion machine of the second kind, led to the discovery of the second law of thermodynamics. The second law of thermodynamics can be precisely stated in the following two forms, as originally formulated in the 19th century by the Scottish physicist William Thomson (Lord Kelvin) and the German physicist Rudolf Clausius, respectively:

A cyclic transformation whose only final result is to transform heat extracted from a source which is at the same temperature throughout into work is impossible.

A cyclic transformation whose only final result is to transfer heat from a body at a given temperature to a body at a higher temperature is impossible.

The two statements are in fact equivalent because, if the first were possible, then the work obtained could be used, for example, to generate electricity that could then be discharged through an electric heater installed in a body at a higher temperature. The net effect would be a flow of heat from a lower temperature to a higher temperature, thereby violating the second (Clausius) form of the second law. Conversely, if the second form were possible, then the heat transferred to the higher temperature could be used to run a heat engine that would convert part of the heat into work. The final result would be a conversion of heat into work at constant temperature—a violation of the first (Kelvin) form of the second law.

Central to the following discussion of entropy is the concept of a heat reservoir capable of providing essentially limitless amounts of heat at a fixed temperature. This is of course an idealization, but the temperature of a large body of water such as the Atlantic Ocean does not materially change if a small amount of heat is withdrawn to run a heat engine. The essential point is that the heat reservoir is assumed to have a well-defined temperature that does not change as a result of the process being considered.

Entropy

Entropy and efficiency limits

The concept of entropy was first introduced in 1850 by Clausius as a precise mathematical way of testing whether the second law of thermodynamics is violated by a particular process. The test begins with the definition that if an amount of heat Q flows into a heat reservoir at constant temperature T, then its entropy Sincreases by ΔS = Q/T. (This equation in effect provides a thermodynamic definition of temperature that can be shown to be identical to the conventional thermometric one.) Assume now that there are two heat reservoirs R1 and R2 at temperatures T1 and T2. If an amount of heat Qflows from R1 to R2, then the net entropy change for the two reservoirs is  (3) ΔS is positive, provided that T1 > T2. Thus, the observation that heat never flows spontaneously from a colder region to a hotter region (the Clausius form of the second law of thermodynamics) is equivalent to requiring the net entropy change to be positive for a spontaneous flow of heat. If T1 = T2, then the reservoirs are in equilibrium and ΔS = 0.

(3) ΔS is positive, provided that T1 > T2. Thus, the observation that heat never flows spontaneously from a colder region to a hotter region (the Clausius form of the second law of thermodynamics) is equivalent to requiring the net entropy change to be positive for a spontaneous flow of heat. If T1 = T2, then the reservoirs are in equilibrium and ΔS = 0.

The condition ΔS ≥ 0 determines the maximum possible efficiency of heat engines. Suppose that some system capable of doing work in a cyclic fashion (a heat engine) absorbs heat Q1 from R1 and exhausts heat Q2 to R2 for each complete cycle. Because the system returns to its original state at the end of a cycle, its energy does not change. Then, by conservation of energy, the work done per cycle is W = Q1 − Q2, and the net entropy change for the two reservoirs is  (4)To make W as large as possible, Q2 should be kept as small as possible relative to Q1. However, Q2 cannot be zero, because this would make ΔS negative and so violate the second law of thermodynamics. The smallest possible value of Q2 corresponds to the condition ΔS = 0, yielding

(4)To make W as large as possible, Q2 should be kept as small as possible relative to Q1. However, Q2 cannot be zero, because this would make ΔS negative and so violate the second law of thermodynamics. The smallest possible value of Q2 corresponds to the condition ΔS = 0, yielding  (5)This is the fundamental equation limiting the efficiency of all heat engines whose function is to convert heat into work (such as electric power generators). The actual efficiency is defined to be the fraction of Q1 that is converted to work (W/Q1), which is equivalent to equation (2).

(5)This is the fundamental equation limiting the efficiency of all heat engines whose function is to convert heat into work (such as electric power generators). The actual efficiency is defined to be the fraction of Q1 that is converted to work (W/Q1), which is equivalent to equation (2).

The maximum efficiency for a given T1 and T2 is thus  (6)A process for which ΔS = 0 is said to be reversible because an infinitesimal change would be sufficient to make the heat engine run backward as a refrigerator.

(6)A process for which ΔS = 0 is said to be reversible because an infinitesimal change would be sufficient to make the heat engine run backward as a refrigerator.

As an example, the properties of materials limit the practical upper temperature for thermal power plants to T1 ≅ 1,200 K. Taking T2 to be the temperature of the environment(300 K), the maximum efficiency is 1 − 300/1,200 = 0.75. Thus, at least 25 percent of the heat energy produced must be exhausted into the environment as waste heat to avoid violating the second law of thermodynamics. Because of various imperfections, such as friction and imperfect thermal insulation, the actual efficiency of power plants seldom exceeds about 60 percent. However, because of the second law of thermodynamics, no amount of ingenuity or improvements in design can increase the efficiency beyond about 75 percent.

Entropy and heat death